1 感知方案:纯视觉 VS 多传感器融合

汽车实现自动驾驶首先需要能够“看见”周围环境,并对环境内的各种静态、动态物体有一定的认知,这个过程便是自动驾驶的“感知”,感知需要依赖安装在车体上的各种传感器实现,例如摄像头、激光雷达、毫米波雷达等等。

目前主流的感知方案有两种,一种是以Waymo为代表的多传感器融合方案,即同时使用摄像头和雷达采集信息,分别利用摄像头和雷达特点,处理各自擅长的数据类型和任务,并将处理结果进行融合得到统一的感知结果;一种是以Tesla为代表的纯视觉路线,即仅使用摄像头作为传感器进行信息采集,构建纯计算机视觉网络进行感知结果输出,类似于人眼的感知模式。

先来看下这几种不同传感器的能力特性:

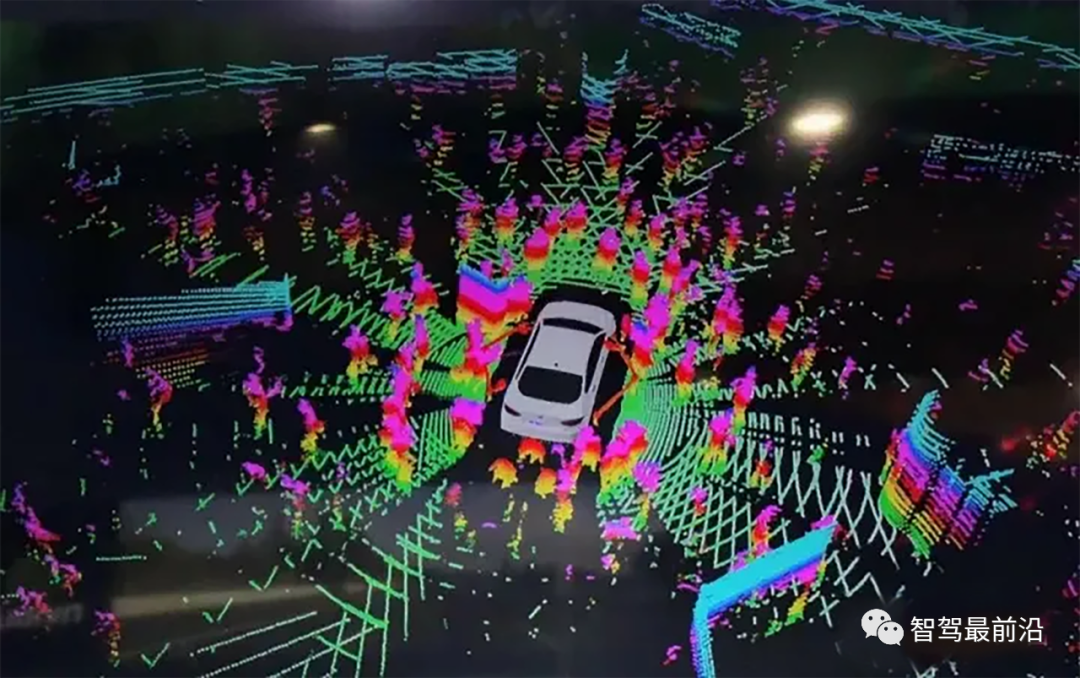

(1)激光雷达:主动传感器,通过发射红外激光并接收反射光的方式判断物体距离,视距范围一般在30~200米,对于特别近的物体很难探测到,空间分辨率较高(角度精度可达0.1度),速度测量精度较低,在黑暗中鲁棒性好,但在雨、雪、雾天气下鲁棒性差,能对物体进行大致分类,但无法识别如车道线、交通标识等二维结构。

(2)毫米波雷达:主动传感器,与激光雷达工作原理类似,区别是使用无线电波而不是激光,视距范围比激光雷达更大,尤其是对近距离物体的探测,毫米波雷达可以实现在1米范围内探测到物体,但毫米波雷达的空间分辨率较低,随着距离增加,对于小特征的分辨能力降低,不过毫米波雷达利用多普勒频移可以直接测量速度,同时在黑暗、雨、雪、雾天气下均能保持良好的鲁棒性,此外,毫米波雷达对物体的分类性能较差,同样也无法识别二维结构。

(3)摄像头:被动传感器,通过被动感光成像来进行识别感知,理论上单摄像头无法准确识别物体距离,立体摄像头可以测量距离,但范围有限,不过实际上特斯拉通过识别算法已经逐步实现了仅通过摄像头测量物体深度,空间分辨率取决于摄像机的参数,在分辨维度上多于激光雷达和毫米波雷达,可以同时识别到物体颜色等信息,通过物体在图像上时空信息可以计算速度,同时对物体的分类多样性更强,且能够识别车道线等二维结构,但是摄像头目前在黑暗、雨、雪、雾等恶劣环境条件下的鲁棒性很差。

总体来说,激光雷达看得远看得清,但看不见近处,是个远视眼,拥有夜视能力,但对恶劣天气无能为力,同时只能看见三维结构,看不见二维平面结构;毫米波雷达是能看远也能看近,但越远越看不清楚,是个近视眼,不仅拥有夜视能力,且拥有恶劣天气条件下能看见的超能力,不过同样看不见二维平面结构;而摄像头仅凭自身能力很难准确判断距离,但有算法加持,可以发展出这项能力,且摄像头能看见更多的信息,包括车道线等二维结构、物体分类、颜色等,是个超级眼,但在光线不佳、有雨雪雾等恶劣环境下,能力存在短板。

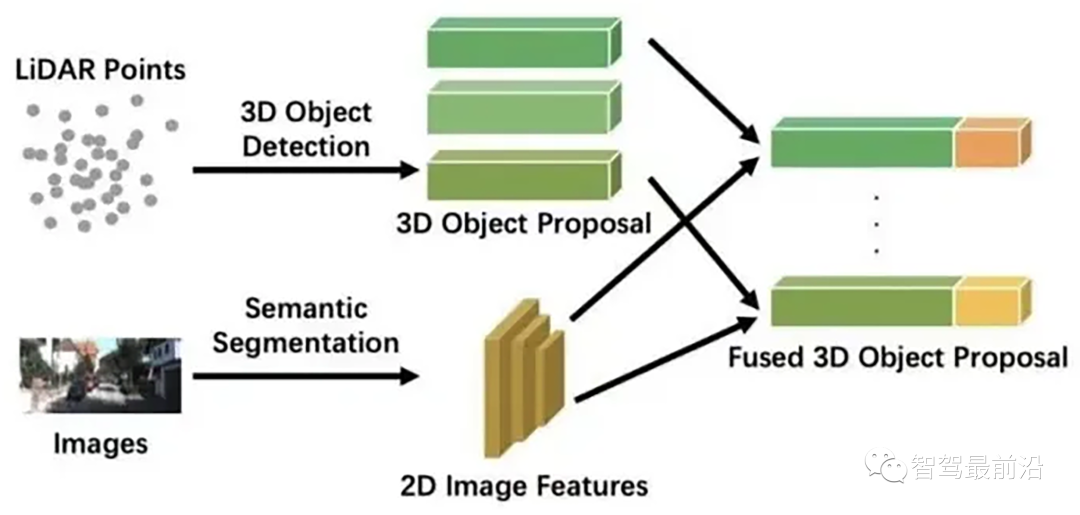

鉴于以上各传感器的特性,目前多传感器融合路线的思路是各取所长,通过激光雷达在各种光照条件下探测距离并完成物体形状分类,通过毫米波雷达探测附近物体距离并保障自动驾驶感知在恶劣天气条件下的鲁棒性,通过摄像头识别物体细致分类及车道线、交通标识、信号灯等参与交通必须掌握的信息。

一般是通过“后融合”方式将不同传感器的感知结果进行融合,即每个传感器各自独立处理生成目标数据,当所有传感器完成目标数据生成后,再由主处理进行融合。

而纯视觉路线仅使用摄像头作为感知传感器,其思路是纵深发展,通过摄像头采集到更多层次的数据信息,并通过持续进步的强大算法,从数据中挖掘到需要的结果。

下面我们分别从工程成本、技术复杂度、发展潜力三个维度来对比下这两条感知路线。

工程成本

相比于激光雷达和毫米波雷达,摄像头的成本是最低的,单目相机的价格一般低于100美元,而激光雷达的价格现在大约在5000美元以内,有专家预测未来几年随着激光雷达的普及,成本会降至500美元以下,但也仍然高于摄像头的成本,因此纯视觉方案的系统成本是要远低于多传感器融合方案的。

技术复杂度

多传感器融合方案的复杂度主要体现在“融合”层面,由于不同传感器特性不同,所采集的数据类型也有很大差异,无论是前融合还是后融合的思路,都需要将不同模态的数据统一映射到同一个专门为融合设计的时空平面,这里面需要考虑融合错位、信息丢失等问题,同时还需要解决当不同传感器感知结果不同时,应该选择信任谁的问题。

而纯视觉方案的复杂度主要体现在感知算法层面,由于都是通过摄像头采集的同模态数据,在数据融合层面困难度比多传感器方案要小得多,但是由于摄像头自身能力的局限性,需要设计更为复杂的算法模型,从摄像头数据中识别到目标信息,例如对距离的计算、在恶劣环境下的识别能力等。

发展潜力

小鹏汽车副总裁吴新宙曾经表示,视觉的潜力是没有止境的,它真的是一个宝藏,长期来看,视觉是无所不能的,但是这个能力的增长是有一个过程的。

基于各类传感器的特性,对于自动驾驶的目标任务,摄像头的能力具有不可替代的部分,例如对二维结构的感知能力,在行车过程中,对车道线、交通标识等二维结构的识别是必不可少的,相反雷达系统相比摄像头的能力优势是有可能通过算法解决掉的,例如是对距离的识别、在夜间及恶劣天气下的鲁棒性问题。

其中视觉方案对距离的识别问题特斯拉目前已经找到解决方案,通过建立BEV鸟瞰坐标系,利用Transformer神经网络能力可以将地面坡度、曲率等参数内化进训练网络,解决了视觉方案仅能基于地面平面假设进行距离计算导致的准确度不够的问题,随着算法的持续训练迭代,纯视觉方案识别距离的能力会逐步逼近甚至超越雷达系统。

针对摄像头夜视能力差的问题,特斯拉提出了直接基于“光子”作为神经网络输入的视觉感知处理的方案,“光子”是摄像头采集数据最原始的形式,传统的视觉方案中会采用ISP(图像信号处理)模块来对摄像机采集到的原始图像数据进行加工,得到质量更好的图像,是模仿人眼的成像原理,但这个步骤会导致一部分原始信息丢失,直接采用“光子”数据可以最大限度的保留原始信息,因此在黑夜中,即使是行人微弱的反光,也会被记录到光子的变化,这使得摄像头获得了超越人眼的夜间视距,发展成熟后可以解决纯视觉方案的夜间鲁棒性问题。

而对于雨雪雾等恶劣天气下的鲁棒性问题,激光雷达也并不能够解决,毫米波雷达虽然受干扰较小,但由于毫米波雷达自身特性,导致其精度会随着距离衰减明显,因此也只能适用于近场问题,相较之下,视觉路线最具解决这个问题的潜力,视觉的基本思路是对人眼的模拟,人类在恶劣天气下开车时,会根据少量可见的线索对其他汽车或行人的运动轨迹进行预测,尽量规避风险,理论上视觉算法足够强大时是可以达到人类在恶劣天气下的感知能力,特斯拉在视觉感知网络中引入了时空记忆能力,使得感知不仅基于瞬时事件,还能结合之前时刻的事件去处理,这提升了神经网络的预测能力,再加上对“光子”的感知,使得纯视觉方案在恶劣天气下的感知能力有大幅提升,最新的特斯拉FSD9.0在恶劣天气下的表现也证实了这一点。

同时,相比多传感器融合的感知架构,纯视觉感知架构更具有美感,融合架构涉及多模态耦合,系统节点多,结构比较冗杂,而视觉架构使用统一结构的数据作为输入,完成端到端学习,输出目标任务结果,整体结构非常简约整洁,这使得纯视觉路线的算法效率和系统运行效率都要更胜一筹。

综合上述几个维度来看,笔者认为由于大部分公司视觉算法还不够成熟,且自动驾驶的安全性至关重要,因此短期需要雷达来补余能力,但随着视觉算法的日渐成熟,多传感器融合方案可能仅是过渡方案,纯视觉方案才是终局。

2 无人驾驶实现路径:渐进式 VS 跨越式

自动驾驶按照SAE等级划分为L1-L5,其中L1-L3一般称为辅助驾驶,驾驶的核心主体仍然是人,而L4-L5称为无人驾驶,驾驶的核心主体是车,由于L4级以上的无人驾驶从技术到工程层面都有相当大的复杂性,因此行业内自动驾驶公司为实现无人驾驶采用了两种不同的路线。

一种是以特斯拉、蔚小理等新势力车企为代表的渐进式路线,采用从L1逐步进阶到L5的发展方式,目前基本处于L2+阶段,正在向L3迈进中,渐进式路线的核心是要建立从数据到算法的迭代闭环,利用不断扩大规模的高质量数据持续优化算法,逐步攻克自动驾驶这项复杂任务的各项核心环节,最终实现全无人驾驶。

一种是以Waymo、百度Apollo等科技公司为代表的跨越式路线,这种路线的基本思想是认为低等级自动驾驶的技术框架难以直接迁移至L4级无人驾驶,在资源有限的情况下需要直接聚焦最终形态,因此寄希望于一步到位实现无人驾驶,主要通过大规模车队获取路测数据来训练无人驾驶算法网络,跨越式路线的核心是要找到适合落地的场景及商业模式,目前已经实现落地的场景主要有Robotaxi、Robobus等乘用场景以及港口、矿山等商用场景。

下面分别从商业模式和面临的主要挑战两个维度来对比下这两条路线。

商业模式

我们知道全面无人驾驶的最终实现是一个长期的战役,不可能一蹴而就,因此无论是哪种路线,选取何种商业模式来保障落地和造血能力以确保可持续发展是至关重要的。

渐进式路线的商业模式主要是通过自行造车或者与车企合作造车实现快速量产落地获取商业利润,会根据用户现阶段的实际需求或适当引导需求逐步落地自动驾驶功能,如高速巡航、自主泊车等,通过OTA软件迭代升级的模式最终自然而然过渡到完全无人驾驶,这套模式会比较重视落地成本,因此在硬件选型、供应链整合、制造水平等方面会投入较大精力。

跨越式路线早期主要是通过资本的注入来供血,但资本是需要回报的,随着技术的不断发展,各企业正在逐步探索商业落地之路,以实现自我造血,目前的商业模式主要有两种,一种是通过Robotaxi、Robobus等满足交通服务需求,获取服务价值,一种是切入特殊的场景,如港口、矿山等,这类场景危险系数高,通过自动驾驶替代人工作业,以节约高额人力成本,这套模式对落地成本相对渐进式没有那么敏感,但要求切入的场景要足够准确且自动驾驶算法要足够有效。

相比较而言,目前渐进式路线的商业模式更为清晰,跨越式路线由于可落地的场景有限,商业模式还在持续摸索中。

主要挑战

渐进式路线和跨越式路线面临的挑战是不同的,前者的主要挑战是进入门槛相对较低导致竞争激烈,后者的主要挑战是政策法规及技术成熟速度不及预期导致长期消耗巨大。

采用渐进式发展路线的主要有三类公司,一类是造车新势力,包括国外的特斯拉,国内的造车新势力蔚来、理想、小鹏等,一类是传统主机厂,例如奔驰、上汽、长城等,还有一类是科技公司,包括华为、百度、小米等,各类势力相继下场争夺市场空间,导致竞争非常激烈,而要由渐进式最终实现无人驾驶需要确保占据一定市场规模,因此最终会有部分企业面临淘汰,目前仅特斯拉处于领先身位,其他家差距并不明显。

而采用跨越式路线要实现落地需要同时具备技术成熟和配套的政策法规完善两大条件,其中技术成熟度层面无人驾驶面临的最大挑战是应对极端场景(corner case)的处理性能,而仅凭路测获取的数据要覆盖全部极端场景可能需要很长周期,再加上有关无人驾驶的政策法规完善时间不可控,因此会导致最终能够实现全场景无人驾驶落地的时间可能遥遥无期,在这个过程中需要消耗的资金量巨大。

因此,由于渐进式路线商业模式清晰以及面临的挑战相对可控,除了少数资金雄厚或者已有场景率先落地的企业坚持只走跨越式路线之外,大部分企业更倾向于选择渐进式路线,包括一些原本走跨越式路线的企业,也开始兼顾渐进式路线,选择两条腿同时走路。

3 写在最后

无论是感知方案还是实现路径的选择,有一个底层思考逻辑是一致的,就是无人驾驶的最终目标是什么,基于目标思考路线。

马斯克在AI Day上提出要将无人驾驶技术迁移至更广泛的场景,打造人形机器人,小鹏、小米等企业入局四足机器人,李彦宏在百度AI开发者大会上也提出“汽车机器人”的概念,因此我们有理由认为无人驾驶不仅仅是提高汽车运行效率的工具,其最终目标或许是形成以汽车为载体的通用人工智能技术。

如果是以打造“通用人工智能”为目标,那么数据的丰富性和质量则非常重要,算法为数据服务,算力为算法服务,数据是驱动人工智能技术发展的“核燃料”,谁先掌握数据,谁便占得实现通用人工智能的先机。

从这个角度看的话,视觉路线能够获得更底层的数据,可以包含颜色、纹理、语义等多维信息,渐进式路线的特性决定了需要持续扩大量产规模,便也更有可能获得覆盖全场景的数据,因此这两个路线可能是更接近无人驾驶最终目标的选择。