网络虚拟化的背景

两个无法满足:

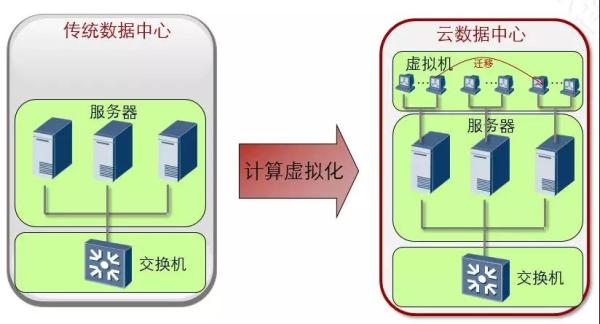

1、计算虚拟化,一台服务器上虚拟多个主机,传统网络无法满足虚拟机间通信的需求;

2、云计算数据中心,传统数据中心无法满足虚拟机的动态迁移。

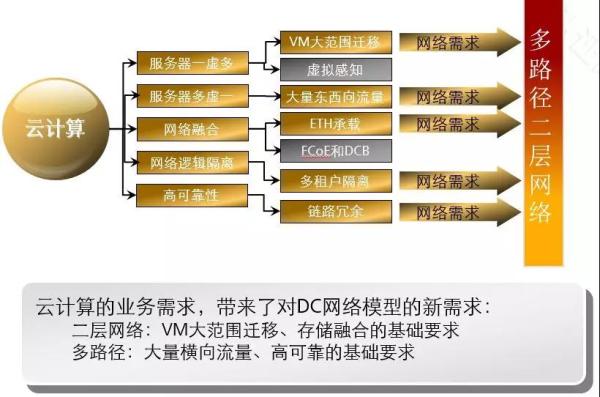

大二层网络需求

- aVM:Virtual Machine

- ETH:Ethernet

- FCoE:Fiber Channel over Ethernet 以太网光纤,FCoE 技术标准可以将光纤通道映射到以太网,可以将光纤通道信息插入以太网信息包内,从而让服务器-SAN 存储设备的光纤通道请求和数据可以通过以太网连接来传输,而无需专门的光纤通道结构,从而可以在以太网上传输 SAN 数据。FCoE 允许在一根通信线缆上传输 LAN 和 FC SAN 通信,融合网络可以支持 LAN 和 SAN 数据类型,减少数据中心设备和线缆数量,同时降低供电和制冷负载,收敛成一个统一的网络后,需要支持的点也跟着减少了,有助于降低管理负担。它能够保护客户在现有 FC-SAN 上的投资(如 FC-SAN 的各种工具、员工的培训、已建设的 FC-SAN 设施及相应的管理架构)的基础上,提供一种以 FC 存储协议为核心的 I/O 整合方案。

- DCB:Data Center bridge 数据中心桥接,DCB 技术是针对传统以太网的一种增强,为了实现以太网不丢包,这种增强型的以太网叫无损以太网,顾名思义就是保证以太网络不丢包。实现这种网络的目的为了解决 FCOE 协议在以太网络中传输时保证不丢包。因为 FCOE 技术实际上就是运行在以太网的 FC 协议,而 FC 协议是不允许丢包的,所以为了实现 FCOE 协议在以太网传输不丢包,引入了 DCB 增强以太网技术。最终实现以太网和新的存储协议 FCoE 都能在以太网络中正常运行。所以把这样的网络称为融合网络。

网络虚拟化视图

物理设备虚拟化:

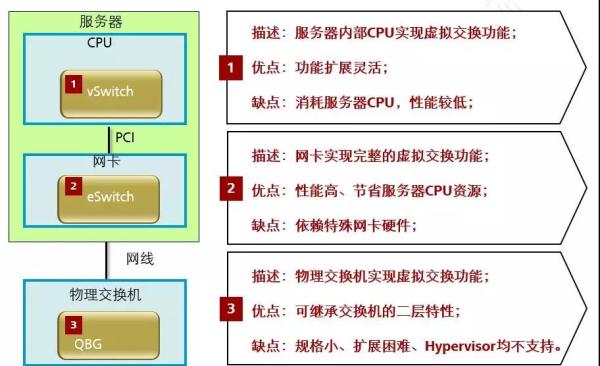

- Qbg:802.1Qbg,bridge Virtual Bridging,2008 年 11 月提出,HP 和 IBM 提出,服务器厂商主导。以 VEPA 模式为基本实现手段(基于 MAC 地址识别虚拟机)

- QBR:2008 年 5 月,Cisco 和 Vmware 在 IEEE 提出 802.1Qbh;2011 年 7 月改名 802.1BR,基于新增 Tag 标识识别虚拟机

- TRILL:Transparent Interconnection of Lots of Links

- SPB:Shortest Path bridge

服务器虚拟化:

- 链路虚拟化:VMDQ、SR-IOV

- 叠加网络:VXLAN,实现虚拟网络与物理网络的解耦

- 软件实现的虚拟交换、虚拟机流量的控制、安全隔离等

- 以及软件实现的 L3-L7 的虚拟化

VMDQ:

- Virtual Machine Device Queue. 虚拟机设备队列. 利用 VMDQ 技术, 可以给虚拟机的虚拟网卡分配一个单独的队列, 是实现 VM 直通的基础

SR-IOV:

- Single Root IO virtualzation。PCIe 的虚拟多设备技术

VXLAN:

- Virtual eXtensible Local Area Network ,虚拟可扩展的 LAN 技术

虚拟交换技术

- vSwitch: virtual Switch,在服务器 CPU 上实现以太二层虚拟交换的功能,包括虚拟机交换、QoS 控制、安全隔离等

- eSwitch: embedded Switch 在服务器网卡上实现以太网二层虚拟交换的功能,包括虚拟机交换、QoS 控制、安全隔离等

网络设备的大二层技术

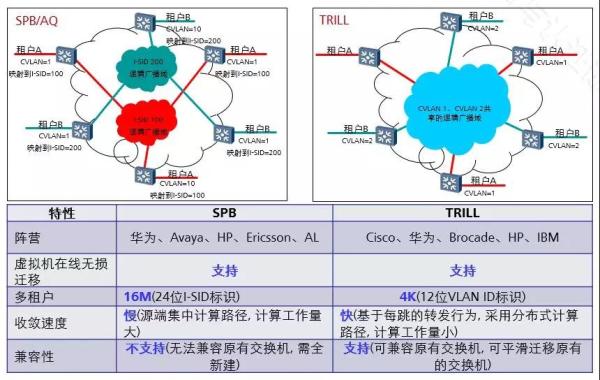

- SPB:Shortest Path Bridging,最短路径桥

- TRILL:Transparent Interconnection of Lots of Links。透明多链路连接

- 两种技术都是基于以太网的二层与动态路由 IS-IS 结合的大二层技术

- 主要区别在:SPB 支持最大 16M 的隔离域标签。但是 SPB 无法与现有的交换机兼容

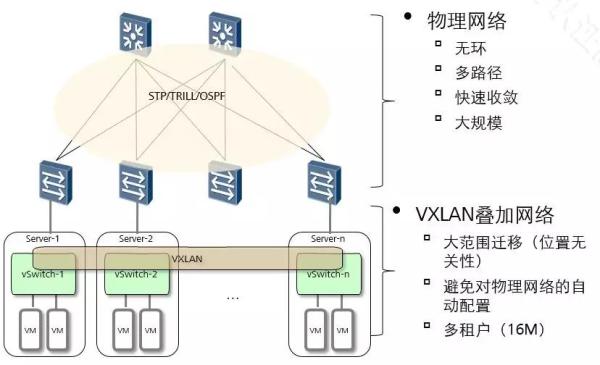

叠加大二层网络技术

- 采用叠加的 VXLAN 大二层网络技术主要的价值在于实现虚拟网络与物理网络解耦,在此基础上提供大二层、16M 多租户的能力

- 物理网络主要实现物理设备的互联互通

网络虚拟化的未来发展预测

1、VM虚拟交换:最终将会出现硬件交换机进入服务器内部的结果,随着交换机芯片价格越来越便宜,芯片集成度越来越高,将交换机转发芯片可以集成到网卡上,或者直接集成到宿主机主板上。

2、存储方面:FCoE基于Ethernet带宽方面的优势,吸收了两者的长处,号称当代最伟大的万兆,具有不丢包、低延时、无损耗的特性,因此FCoE将会逐步取代FC,使后端的存储网络和前端数据网络彻底融合,进一步简化网络结构,降低组网成本。

3、二层交换虚拟化:TRILL将会成为主流,在后续巨型数据中心内,基于IP层面的交换会导致传输效率降低和部署复杂度提升,因此仍然会以Ethernet技术为主,而TRILL是最有发展前景的公共标准。各个厂商的私有技术只能在小规模数据中心内有所应用。

4、设备一虚多:服务器建VM是为了把物理服务器空余的计算能力全都利用上,而在云计算数据中心里,网络设备的接口密度和性能应该始终是供不应求的,因此网络设备一虚多技术应该不是未来的方向。

5、设备多虚一:通过各个层次上的网络设备的多虚一,可以优化组网的逻辑结构,简化设计和管理,同时解决二层多路径等问题,提高接入带宽和上行带宽。优点很多,但是设备多虚一技术的进一步发展,取决于交换机主控芯片的性能提升情况。